Mistral AI, la société française d'intelligence artificielle, annonce aujourd'hui le lancement de Mistral 3, sa nouvelle famille de modèles de langage. Cette génération comprend trois modèles compacts ainsi qu'une version majeure baptisée Mistral Large 3. L'annonce intervient peu après la présentation de GPT-5.1 d'OpenAI, Gemini 3 de Google, Claude Opus 4.5 d'Anthropic et DeepSeek-V3.2.

Mistral Large 3 : puissance et open source

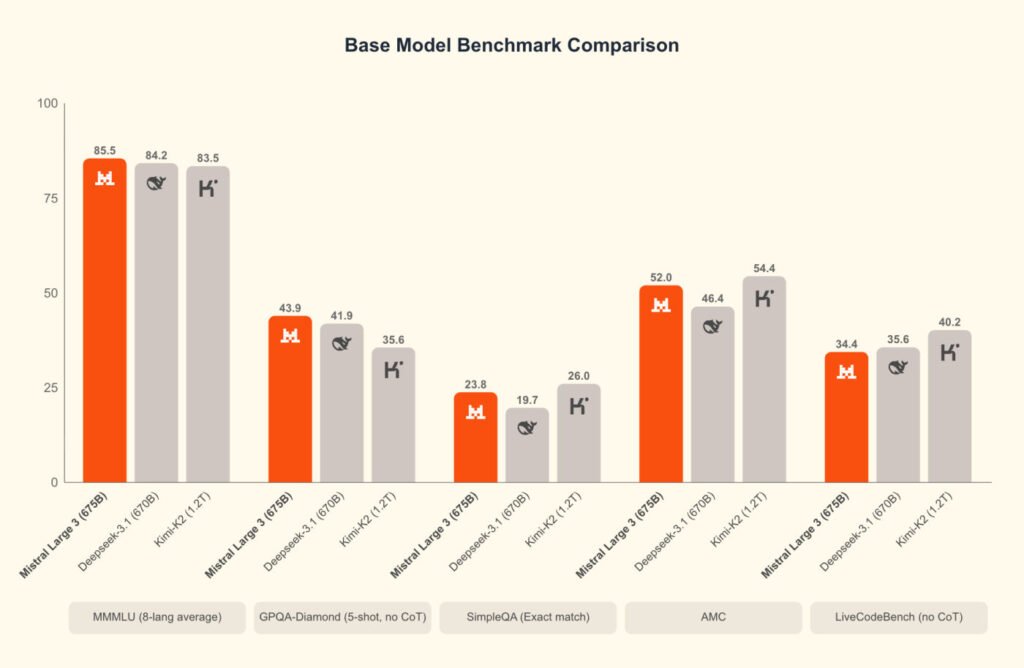

Fer de lance de cette annonce, Mistral Large 3 marque une évolution significative dans les capacités de pré-entraînement de l'entreprise. Il s’agit d’un modèle de mélange d’experts (MoE) clairsemé, le premier du genre depuis la famille Mixtral. Entraîné de toutes pièces sur 3 000 GPU Nvidia H200, il totalise 675 milliards de paramètres, dont 41 milliards sont actifs lors de l'inférence.

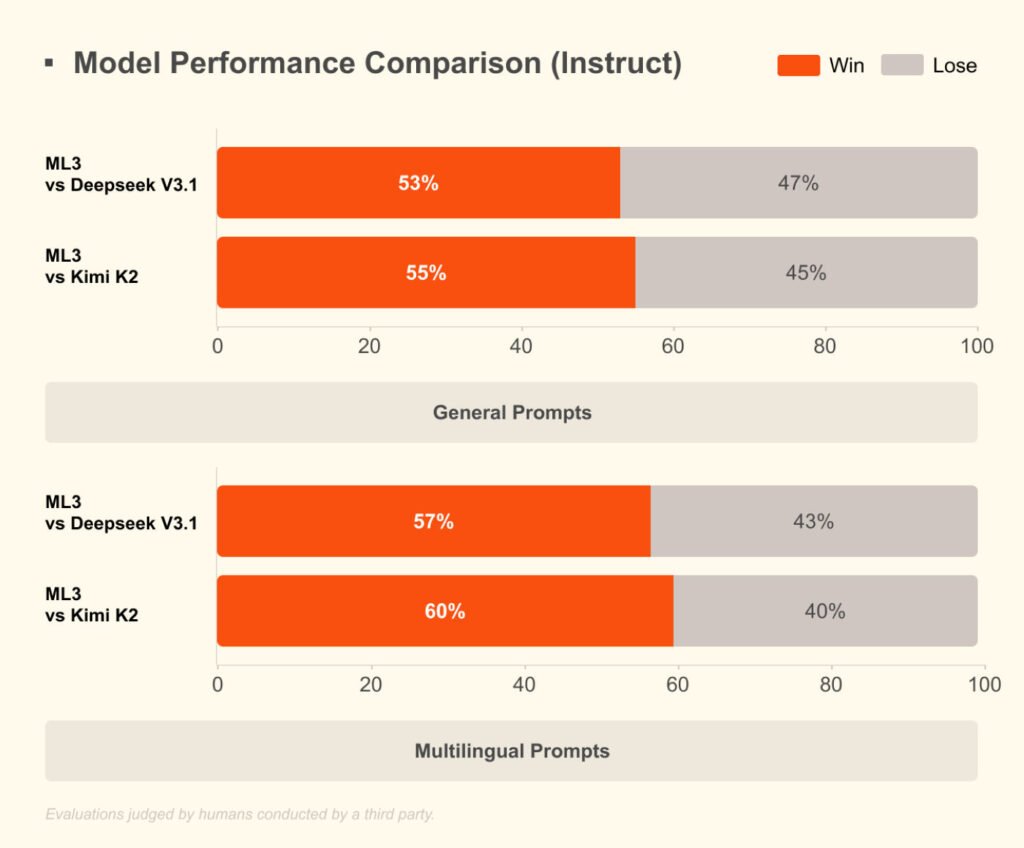

Ce modèle rivalise avec les meilleures solutions actuelles à poids ouvert. Il démontre des compétences avancées en compréhension d’images et excelle dans les conversations multilingues, notamment en dehors du couple anglais-chinois. Dans le classement LMArena, il fait ses débuts à la deuxième place dans la catégorie des modèles open source sans raisonnement.

Bien que les versions de base et pédagogique soient disponibles immédiatement pour permettre une personnalisation en entreprise, une variante axée sur le raisonnement est prévue prochainement.

Pour garantir une accessibilité maximale, Mistral a collaboré étroitement avec Nvidia, Red Hat et vLLM. Ce partenariat a permis une co-conception logicielle et matérielle approfondie :

- Formats optimisés : Un point de contrôle au format NVFP4, conçu avec llm-compressor, est disponible pour une exécution efficace.

- Compatibilité serveur : Mistral Large 3 peut fonctionner sur un seul nœud 8×A100 ou 8×H100, ainsi que sur les systèmes Blackwell NVL72.

- Intégration technique : Nvidia a intégré un support de pointe avec Blackwell et prend en charge une inférence efficace via TensorRT-LLM pour l'ensemble de la famille Mistral 3.

Ces efforts permettent aux développeurs de gérer des charges de travail à haut débit et dans un contexte long, du centre de données aux robots.

Ministérielle 3 avec efficacité et raisonnement

Pour les cas d'utilisation locaux et Edge, la société propose la famille de modèles Ministral 3. Il existe en trois tailles de paramètres : 3B, 8B et 14B. Contrairement au modèle Large, ces versions denses sont déjà proposées en trois variantes : base, instruction et raisonnement.

La gamme Ministral vise le meilleur rapport performance-coût du marché. Dans des conditions réelles, ces modèles égalent ou surpassent leurs concurrents tout en générant souvent beaucoup moins de jetons, augmentant ainsi leur efficacité.

La variante de raisonnement à 14 milliards de paramètres illustre cette performance en atteignant 85% sur le benchmark AIME '25. Ces modèles intègrent également des capacités natives de compréhension des images, offrant ainsi une solution complète pour les besoins des développeurs.